Generative AIのための最近の技術動向

WebAssemblyやWebGPUなど、トレンディな技術についての話

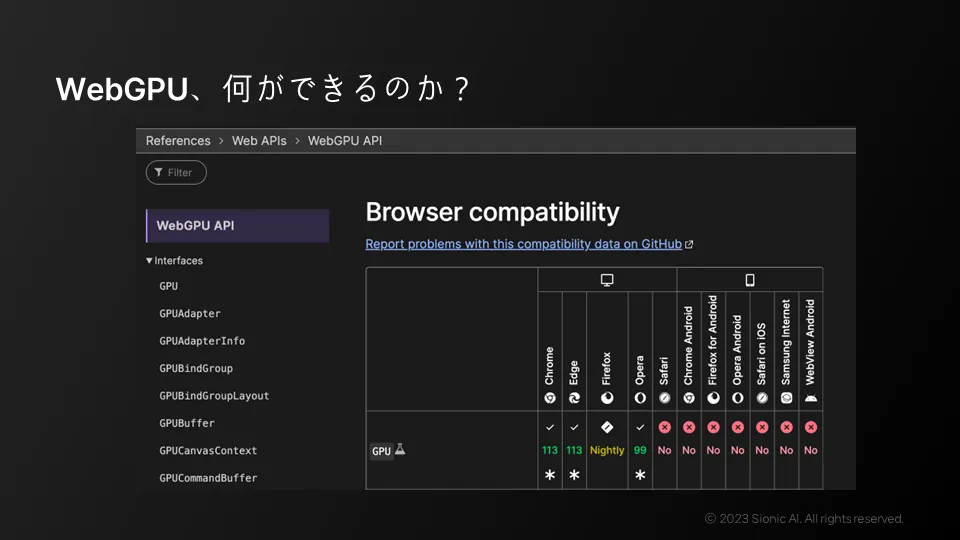

WebGPU

•

WebAssemblyなど比較的最近使われ始め、JavaScriptの代替品ではなく補完材として機能

•

GPGPUベースの汎用演算加速が強み

•

2023年5月Chrome113から試験的に動作

•

Microsoft DirectX、クロノスグループのバルカン、アップルのメタルなど

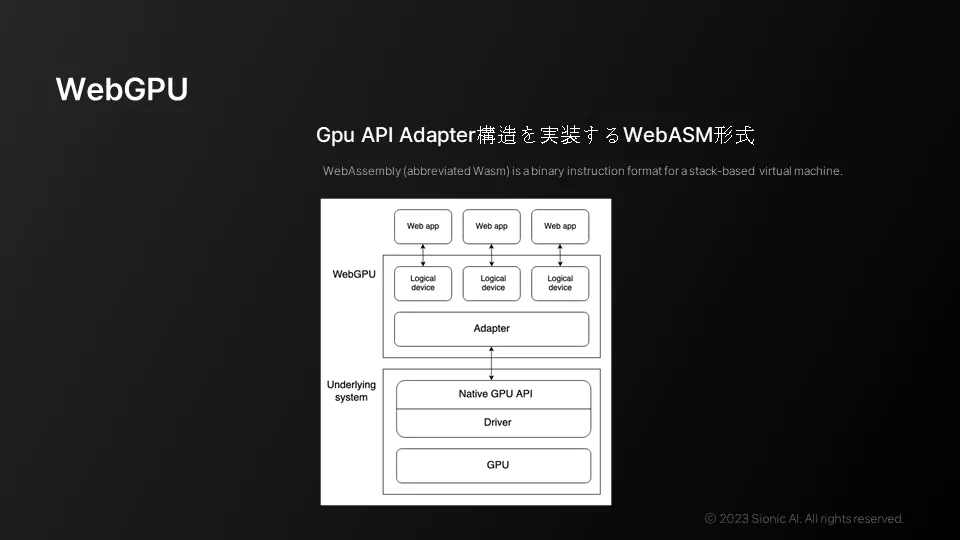

WebGPU構造

•

Web機能拡張でWebアセンブリはネイティブ言語で構成される。

•

Webアセンブリはコンパイル後、Web経由でファイルとして渡され、実行される。

•

Web GPUはWebアセンブリベースで高性能のために作られた(比較的)高レベルのapi Apapterを実装している。

モデルプラットフォームのコストと技術

•

ネイティブGPU APIとWebGPU APIなどプラットフォーム別に動作

•

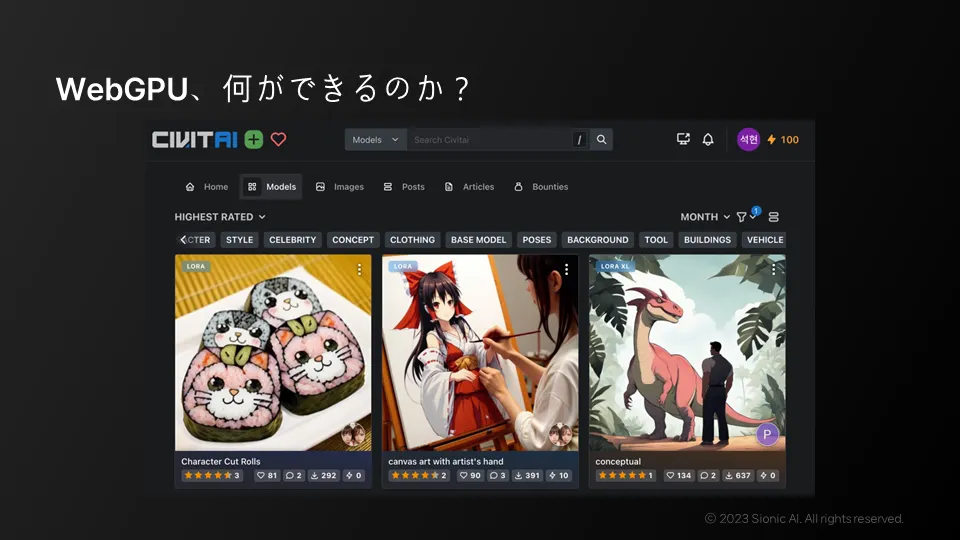

Diffusionモデルを流通させるプラットフォーム

•

モデルのコストと実験コストの問題以外にも、標準や技術的な問題などが存在

現状で私たちにできること

•

性能とパーソナライズを考慮したAIモデル

•

パーソナライズされたLLMは、携帯電話に搭載されたときにAR技術を革新する可能性

Web ベースのアプリケーションでのNativeサポート

•

Chromiumベースのオープンソースのメリットをまとめ

•

ElectronでビルドしたアプリケーションでGPUの加速が可能

技術的な選択肢を考えながら、生成型AR技術を活用する方法

•

インフラ構築には多くの費用がかかるが、パーソナライズされたLLMと分離されたGPU modderを使用することは良い選択肢である

•

パーソナライズされたLLMは携帯電話に搭載してAR技術を革新可能

•

今は生成型AR技術を活用するのに最適な環境である

•

従来のネイティブGPUに比べて高い生産性を持つ

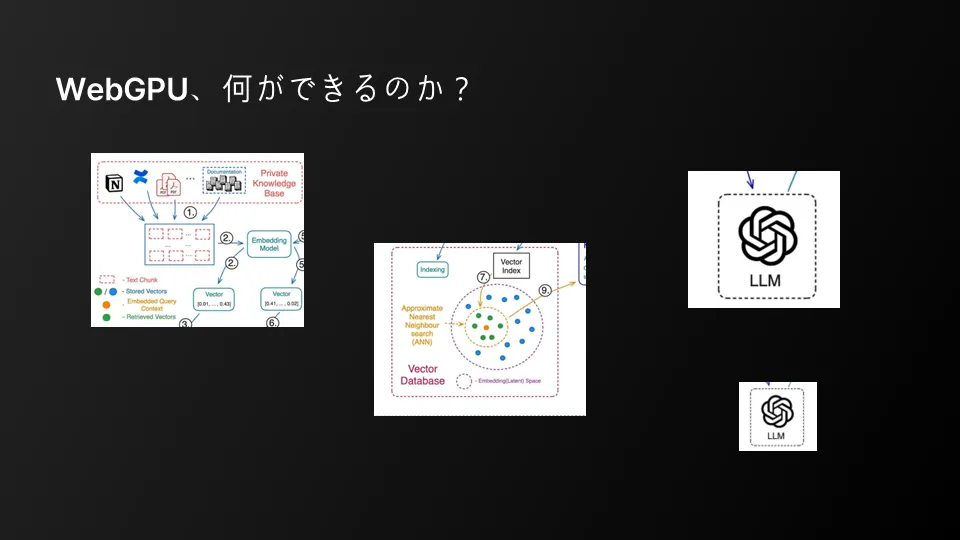

pain point

•

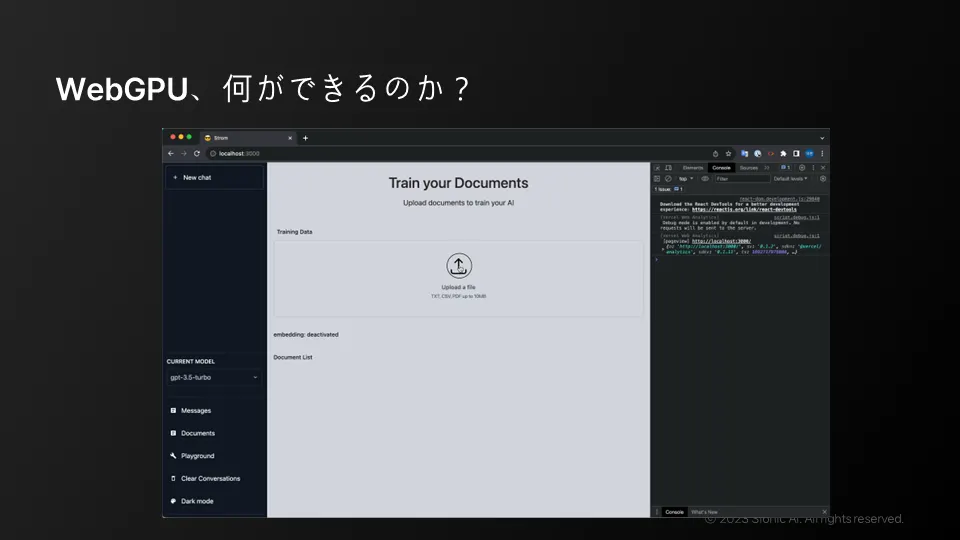

生成型AIを完全にカスタマイズすることは難しい。

•

検索ベースの知識を多く使用,またはEmbeddingモデルを使用する。

私たちができる戦略的選択

•

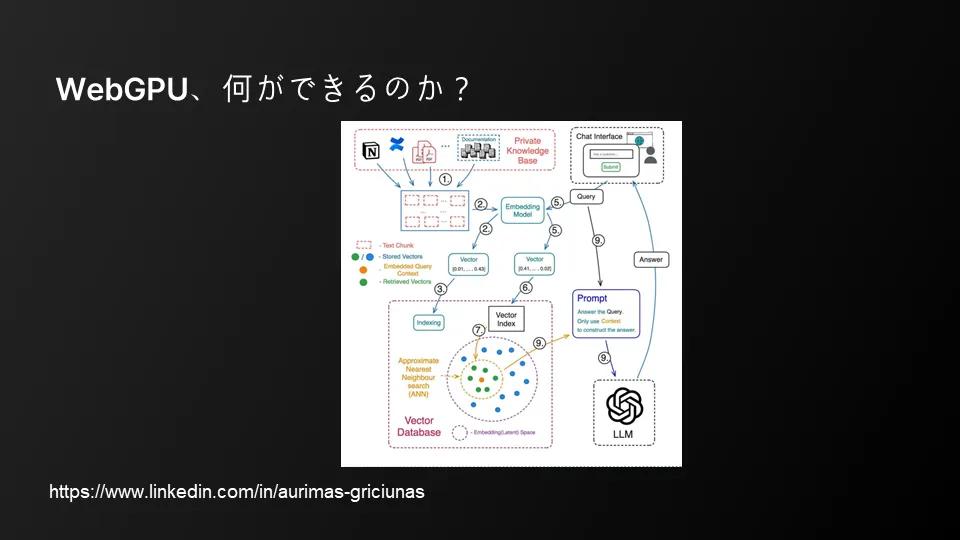

チューニングがずれることや、既存の論理的な知識を忘却する問題を解決する

•

プライベートな知識が外部に漏洩する可能性を下げる

•

ベクターDBを通してプロンプトにインジェクションする方式でかなり多くのことが解決できると期待

•

パーソナライズされたLLMを携帯電話に入れて持ち歩き、それを通じて世界にポジティブな影響を与える方向性!

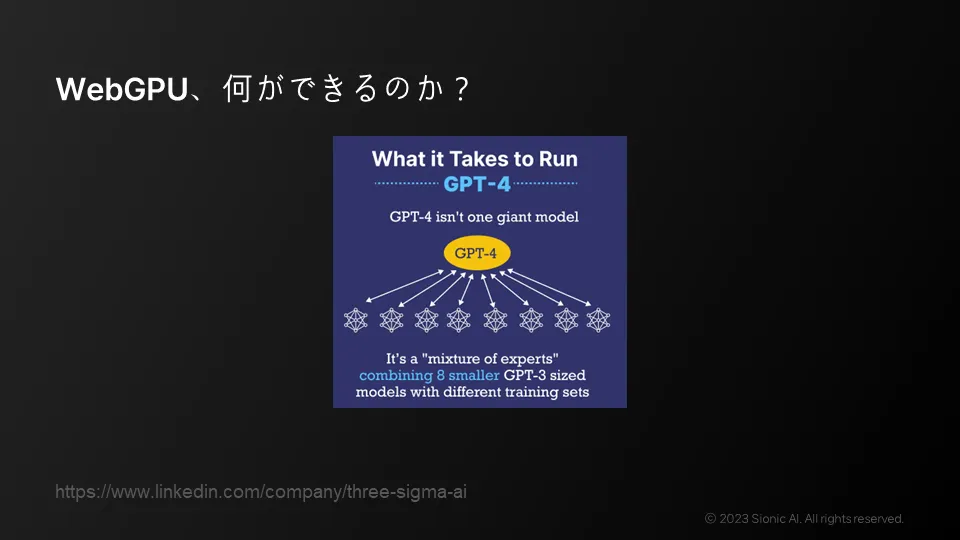

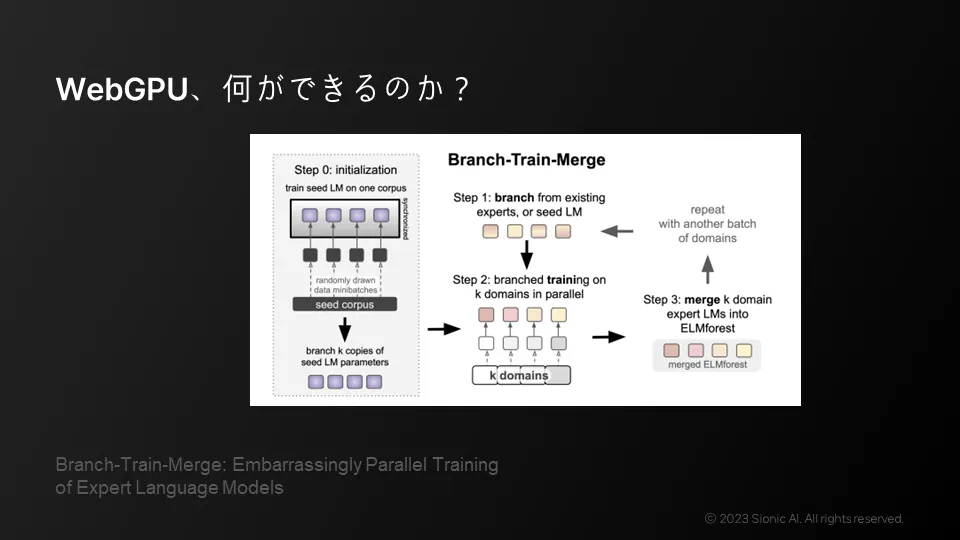

モデル構成

•

インフラ構築には多くの費用がかかるが、パーソナライズされたLLMと分離されたGPUモジュールを使用することは良い選択肢である!

•

しかし、まだモバイル対応は不十分な初期段階である。

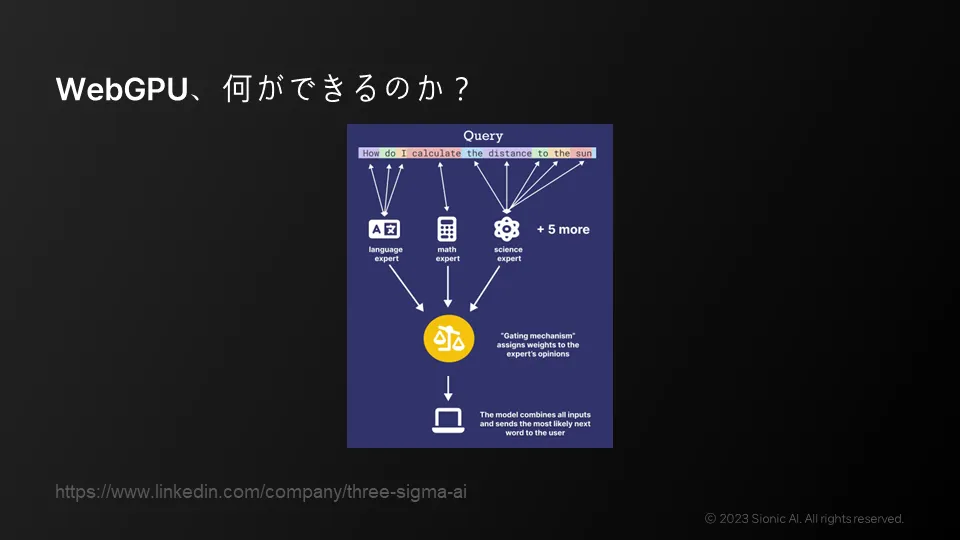

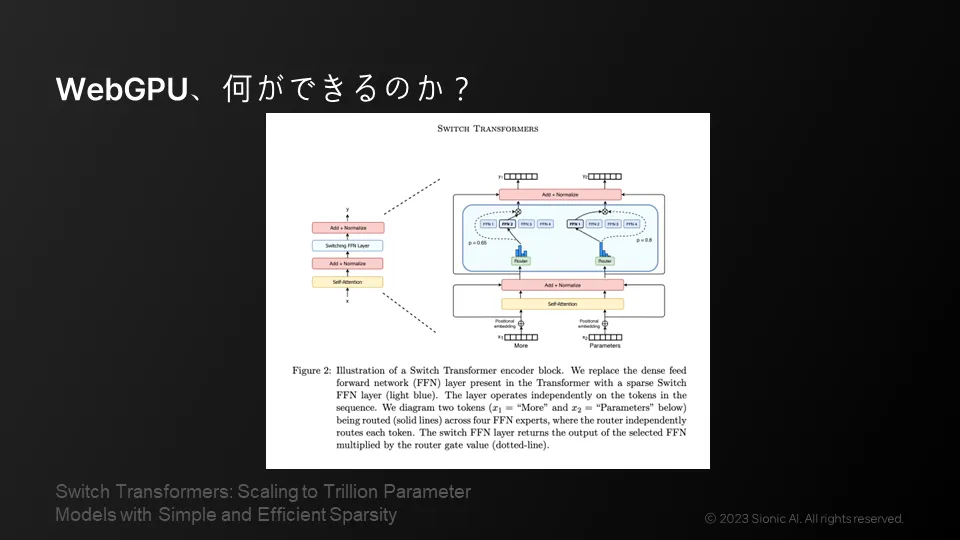

パーソナライズされたLLM

•

一般的な言語を構成するモデル、計算力を担当するモデル、科学的な知識と常識を担当するモデルなど、複数の専門家モデルを連合

•

パーソナライズされたLLMを携帯電話に搭載し、AR技術を革新可能

•

今は生成型AR技術を活用するのに最適な環境

•

WebGPUを使う小さなモデルがより個人的なLLMを担当し、同時に大きなLLMが与える論理構造と答えの多様性を事前に指示

•

高い推論性能を持つLLMモデルをバックボーンとして、当社や個人に合わせた専門家モデルを個人デバイス(またはGPU、ウェブサイト)に搭載。

技術的な選択肢を考えながら生成型AR技術を活用する方法

•

インフラ構築には多くの費用がかかるが、パーソナライズされたLMMと分離されたGPU modderを使用しても良い選択である。

•

パーソナライズされたLMMは、携帯電話に搭載することでAR技術を革新することができる。

•

今は生成型AR技術を活用するのに最適な環境である。

•

MLCのようなオープンソースの領域に非常に大きな進歩をもたらす。

•

最近Multi GPUとAMDに関する内容もリリースされ始めた。

•

ApacheのTVMなどを通じてML関連のパイプラインや実際のオペレーションをコンパイルできるようになる。